Meses antes de Adolf Hitler invadir a Polônia, Isaac Asimov começou a série de contos Eu, Robô, na qual apontava para um futuro de ordem e progresso em que os robôs assumiriam todo trabalho pesado ou arriscado. E pouco antes de Pearl Harbor, formulou as famosas “três leis da robótica”, para garantir a humanos escaldados por um suposto “complexo de Frankenstein” que jamais teriam de temer suas máquinas, programadas para não ferir seres humanos.

Tais leis não passavam de um artifício para tornar possíveis os enredos cerebrais da quase utopia tecnológica concebida na juventude do escritor de ficção científica depois conhecido como “o Bom Doutor”. Mas na realidade do século XXI, no qual robôs construídos para ferir e matar estão em ação em várias frentes de batalha, há quem exija com seriedade não um programa para impedir que robôs façam o mal, o que seria pedir demais, mas que ao menos respeitem as leis de guerra e evitem crimes contra a humanidade.

“Sobre a Responsabilidade Moral de Robôs Militares” não é um conto de ficção científica, e sim um artigo acadêmico de Thomas Hellström, professor de Ciências da Computação da Universidade de Umeå, Suécia, publicado na revista Ethics and Information Technology, de setembro de 2012. Embora ainda estejam longe de ter inteligência ou consciência, muitos robôs atuam com autonomia para decidir e agir em razão do que captam com seus sensores. O Samsung SGR-A1, robô-sentinela sul-coreano criado em 2006, pode disparar uma metralhadora ao detectar humanos sem intervenção humana adicional, embora possa ser programado para não disparar se quem se aproxima pronunciar a senha correta.

Também robótico e potencialmente autônomo, o sistema Phalanx de canhões antiaéreos automáticos, usado pelos Estados Unidos desde os anos 1980, é “responsável” pela morte de ao menos dois militares e um técnico civil e a perda de um avião de ataque por “fogo amigo”. O sistema Aegis de lançamento automático de mísseis antiaéreos, de maior alcance, envolve os mesmos riscos e em 1988 levou o cruzador estadunidense Vincennes a abater um Airbus civil iraniano e matar 290 passageiros. Embora estivesse em modo semiautomático, o sistema o identificou, erradamente, como um caça F-14 e nenhum dos 18 oficiais e técnicos da tripulação o questionou, embora o avião seguisse uma rota comercial rotineira e um ataque iraniano a um navio dos EUA fosse, naquela conjuntura, muito improvável.

O slogan do lobby das armas é que “armas na matam pessoas, pessoas matam pessoas”. Mas que pessoas responsabilizar quando a arma é um robô? Às centenas que colaboraram para programá-la? Ao oficial que mandou ativá-la? Ao ministro, general ou almirante que decidiu adotá-la, apesar dos riscos? E se o programa puder aprender com a experiência e desenvolver “comportamentos emergentes” imprevistos, como já existem exemplos, de modo que ninguém possa prever exatamente como se comportará em uma dada situação? Hellstrom receia que o uso de robôs sirva como pretexto para políticos, generais, oficiais e soldados se isentarem de responsabilidades e propõe que a construção e o uso de robôs autônomos sem “restrições normais” embutidas sejam tratados como crimes de guerra.

Quem é responsável se um crime contra a humanidade for cometido por máquinas? Políticos, generais, soldados ou programadores?

Outro acadêmico, o professor Ronald C. Arkin, do Instituto de Tecnologia da Geórgia (Georgia Tech), propõe um plano de pesquisa de algoritmos de “regulação ética” para que tais armas, ao serem postas em combate, sejam capazes de disparar e suspender fogo de acordo com as leis de guerra internacionais, o que acredita ser uma meta factível em 10 a 20 anos.

Quando os robôs ainda eram ficção cientifica

As três leis da robótica, propostas por Isaac Asimov em seu conto Círculo Vicioso (no original, Runaround), de outubro de 1941, incluído na coletânea Eu, Robô:

PRIMEIRA LEI

“Um robô não pode ferir um ser humano ou, por omissão, permitir que um humano seja ferido.”

SEGUNDA LEI

“Um robô deve obedecer às ordens dadas a ele por seres humanos, exceto quando tais ordens entram em conflito com a Primeira Lei.”

TERCEIRA LEI

“Um robô deve proteger a sua própria existência , contanto que tal proteção não entre em conflito com a Primeira ou a Segunda Lei.”

Arkin cita um episódio documentado da guerra no Iraque, no qual o piloto de um helicóptero armado atirou em três supostos insurgentes que se moviam entre caminhões estacionados, divisados por infravermelho. Um sobreviveu e escondeu-se debaixo de um dos caminhões. Quando saiu, o piloto avisou que o homem estava ferido. Mesmo assim, recebeu do comando a ordem de liquidá-lo, em uma violação flagrante das leis de guerra. Asimovianamente , Arkin acredita que um drone de guerra autônomo poderia ser programado de modo a não disparar em situações como essa, agindo de forma “mais moral” do que soldados humanos.

Em suma, por julgar inevitável a chegada de tais armas ao campo de batalha, Arkin propõe que ao menos sejam reguladas para não matar indiscriminadamente. Outros especialistas julgam, ao contrário, que sua pesquisa, pois em 2006, Arkin recebeu uma bolsa de três anos do Exército dos EUA para desenvolver uma “consciência artificial” para guiar robôs em batalha independente do controle humano, cria a ilusão de que armas robóticas “morais” são factíveis e sabota o esforço para limitá-las.

As leis de guerra supõem que há alvos legítimos (combatentes inimigos) e ilegítimos (civis desarmados, soldados feridos ou rendidos), razões pelas quais armas de destruição em massa, minas terrestres, bombas de fragmentação e bombardeiros indiscriminados, que não permitem distinguir alvos, são malvistos e entram na mira de campanhas por sua proibição, ao menos quando usadas por regimes hostis ao Ocidente, como o da Síria.

Robôs militares começam a receber a mesma atenção. Mary Ellen O”Connell, professora de Direito da Universidade Notre Dame, em Indiana (EUA), lidera uma campanha pela proibição de ataques com drones, robôs aéreos teleguiados cujo uso se tornou rotineiro no governo Barack Obama. No seu entender, drones com mísseis são armas de guerra e só deveriam ser usados em um conflito declarado e não em países como o Iêmen e o Paquistão, que não estão em guerra com os EUA.

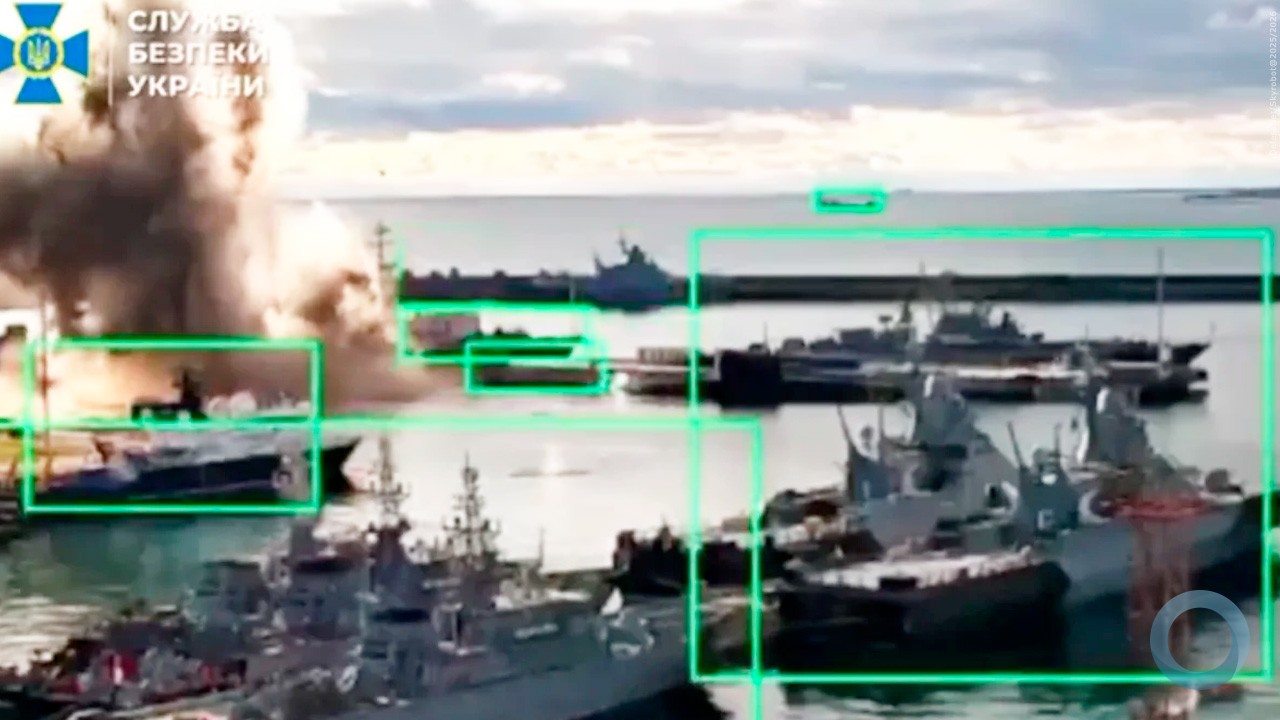

Noel Sharkey, professor de Robótica da Universidade de Sheffield, acrescenta que a própria entrada em operação dessas armas foi violação. A Convenção de Genebra requer que novas armas sejam testadas durante seu desenvolvimento para asseguram que não causem danos indesejáveis a civis, mas os drones Predator não passaram por essa etapa. Planejados como equipamentos de reconhecimento,que não exigem mais testes , foram improvisadamente equipados com mísseis Hellfire em 2001, driblando essas exigências e hoje estão sendo substituídos por uma versão maior e mais letal, o Reaper. Há também um equipamento terrestre análogo, o minitanque automático armado SWORDS, ainda não usado em combate.

Drones são frequentemente usados em ataques em aldeias e acampamentos onde não há sinal de violência iminente, contra alvos “suspeitos” por parecerem jovens e se reunirem, ou qualquer outro comportamento vagamente equívoco. James Jeffrey, ex-militar que escreve para o jornal britânico The Guardian, conta como preparou um Predador para disparar e subitamente se deu conta de que a confusa imagem na tela do computador não era um taleban interrando uma bomba na estrada e sim uma criança brincando com terra.

Um drone já trás à guerra grau extra de desumanização em relação a um avião ou tanque. E um robô autônomo?

Quando Jeffrey comandava um tanque no Iraque em 2004, as ordens ao artilheiro ainda reconheciam alguma humanidade no inimigo: “Ganha o homem, 100 metros à frente”. Cinco anos depois, no Afeganistão, só se falava de “pontos quentes”, “pax (jargão para “homens de idade militar”)múltiplos no terreno”, no máximo “ perseguir um alvo” ou “maximizar a cadeia de destruição”.

Nesse caso, o disparo permanece em tese sob controle humano, mas o uso do robô distancia o adversário ainda mais( o operador de um drone no Afeganistão pode estar em uma base em Nevada, a 12 mil quilômetros), elimina o risco do atirador e dilui sua responsabilidade ao criar um grau adicional de desumanização em relação ao usuário de um tanque ou avião de ataque. Quando se trata de um robô autônomo como o que os EUA pretendem dispor no médio prazo, um terceiro grau de abstração é introduzido entre os militares e seu alvo.

Ética em bytes. Será possível programar um robô como o SGR-A1 para aceitar uma rendição?

Por insistência do senador republicano John Warner, preocupado em minimizar as mortes de soldados e afastar as preocupações dos eleitores com o envolvimento dos Estados Unidos em guerras no exterior, o orçamento do Pentágono de 2001 previu um programa de pesquisas para que um terço das aeronaves de ataque fosse não tripulado até 2010, bem como um terço dos veículos terrestres de combate até 2015. Essas metas ainda não foram atingidas, mas 50 a 80 países já usam sistemas robóticos militares , aéreos, terrestres ou navais, que constituíram um mercado mundial de 5,8 bilhões de dólares em 2010 e devem chegar a 8 bilhões em 2016, segundo um estudo da ABI Research. A maioria deles, como os Predador, Reaper e SWORDS , ainda são apenas semiautônomos, mas o passo seguinte está suficientemente próximo para exigir um debate sério sobre ética e leis de guerra. (Carta Capital)