O acordo-quadro entre a Suíça e a União Europeia (UE) chegou ao fim no mesmo momento em que Bruxelas está se preparando para regulamentar a vigilância em massa com base em inteligência artificial (IA). Isso põe em questão o futuro das normas de privacidade na Suíça, onde os eleitores acabam de aprovar uma das leis antiterroristas mais severas da Europa.

No final de maio, após sete anos de negociações, o Conselho Federal abandonou o acordo-quadro com a União Europeia, fragilizando sua relação bilateral com Bruxelas, que chegou a um ponto historicamente baixo.

Pouco tempo depois, em 13 de junho, o povo suíço votou expressamente a favor da lei federal de combate ao terrorismo, que confere à polícia maiores poderes para intervir preventivamente. A ruptura com a UE chega num momento crucial dos esforços europeus para combater o uso de tecnologias de vigilância na população, não apenas por empresas privadas, mas também pela polícia.

A Comissão Europeia está trabalhando na primeira legislação do mundo para regulamentar a inteligência artificial (IA). A proposta atualmente em discussão aborda os riscos de tal tecnologia e estabelece obrigações nítidas no que diz respeito a seus usos específicos.

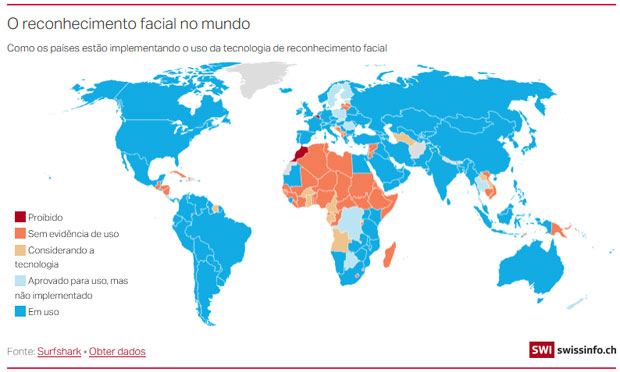

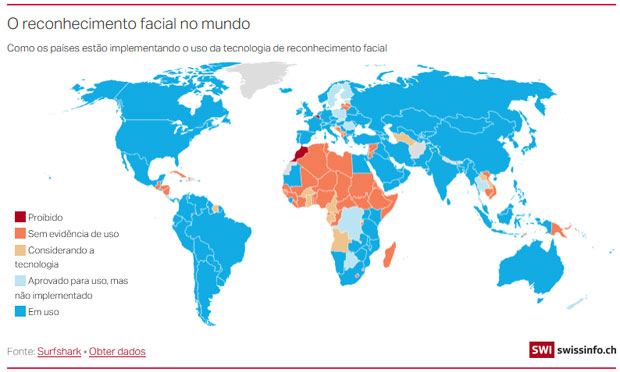

Na mira de Bruxelas estão particularmente os sistemas de identificação biométrica (incluindo o reconhecimento facial), que são cada vez mais utilizados em espaços públicos – muitas vezes sem o conhecimento das pessoas – para fins de vigilância, coleta de dados e aplicação da lei.

No início deste ano, a Anistia Internacional lançou uma campanha contra o uso de tecnologias de reconhecimento facial para fins de identificação, tanto por agências estatais quanto por atores do setor privado. De acordo com a ONG, “nas mãos das autoridades policiais, o reconhecimento facial corre o risco de se tornar uma arma contra as comunidades marginalizadas em todo o mundo”.

Ao mesmo tempo, ela também se pronunciou contra a nova lei suíça sobre medidas policiais de combate ao terrorismo, afirmando que o texto era “perigosamente vago” e que seria “uma ameaça para o futuro”. Na medida em que a lei contribui para o aumento da vigilância, ela também pode levar indiretamente a um aumento do uso daqueles sistemas de identificação que Bruxelas está tentando proibir, afirmam observadores.

“No contexto liberal-democrático europeu, a lei suíça é certamente uma das mais extremas. Em alguns casos, ela concede poderes sem precedentes à polícia federal”, adverte Lukas Hafner, coordenador da campanha de Tecnologia e Direitos Humanos da Anistia Suíça. No ano passado, até mesmo o Conselho Europeu expressou suas preocupações sobre as graves violações dos direitos humanos e fundamentais que essa lei permitiria.

Para onde olha o olho eletrônico da lei?

Embora a lei antiterrorista não mencione explicitamente a vigilância por câmera, ela permite que a polícia federal (Fedpol) solicite a “vigilância eletrônica de um potencial terrorista” por meio, por exemplo, de uma pulseira eletrônica (Art. 23q).

Mais controverso ainda é o fato de que as medidas de vigilância eletrônica podem ser decididas pela polícia federal sem a aprovação de um tribunal, e que os dados coletados podem ser utilizados para um fim diferente daquele previsto por lei, destaca Frédéric Bernard, professor de direito público da Universidade de Genebra.

“Essa lei não impede muita coisa, esse é o problema”, afirma. Quando consultada pela SWI swissinfo.ch, a Fedpol disse que não utiliza sistemas de reconhecimento facial e negou qualquer ligação entre as medidas preventivas mencionadas na nova lei e o uso de tais tecnologias. Algumas forças policiais cantonais, no entanto, já utilizam sistemas biométricos para investigar delitos no caso de processos criminais.

A polícia de St. Gallen, por exemplo, faz uso do Griffeye Analyze DI Pro, um software de investigação sueco que analisa grandes quantidades de dados usando IA e reconhecimento facial. O website do fabricante, Griffeye Technologies, afirma que o software pode “associar metadados a fontes abertas na Internet” e identificar rostos a partir de grandes quantidades de “imagens do mundo real”.

Mundialmente, pelo menos quatro bilhões de pessoas têm um perfil na web no qual essas “imagens do mundo real” poderiam ser obtidas. Estudos como o realizado por Joy Buolamwini, uma pesquisadora do MIT Media Lab, e Timnit Gebru, ex-pesquisadora de ética de IA no Google, mostram que os softwares comerciais de IA são menos exatos quando se trata de analisar os rostos de pessoas de pele escura e mulheres.

Hanspeter Krüsi, responsável pela comunicação da polícia de St. Gallen, nos explica por e-mail que o material coletado seria “comparado pelo sistema a imagens de bancos de dados da polícia para procurar por correspondências”. As verificações finais seriam, então, realizadas por uma pessoa real.

“Cada cantão deve decidir por si só se deseja utilizar essa tecnologia com prudência e se tem a base legal necessária para fazê-lo”, escreve a Fedpol à SWI swissinfo.ch. Mas, na ausência de leis claras que definam a base para a aplicação das tecnologias, quem pode decidir o que é prudente e o que não é? “Há um risco de arbitrariedade e de abuso que não pode ser negligenciado, sobretudo devido a conceitos formulados de forma imprecisa”, explica Jean-Philippe Walter, o comissário suíço do Conselho Europeu para a Proteção de Dados.

O novo documentário "Coded Bias" mostra a parcialidade dos algoritmos e as falhas na tecnologia de reconhecimento facial descobertas pela pesquisadora do MIT Joy Buolamwini (em inglês):

Todos os olhos na Suíça

Nos últimos tempos, a Anistia Internacional tem acompanhado de perto a situação dos direitos fundamentais na Suíça, especialmente devido ao risco do aumento da vigilância indiscriminada da população. “A lei suíça antiterrorismo levará nitidamente a uma maior vigilância de um número maior de pessoas, uma vez que a polícia federal pretende identificar ‘terroristas em potencial’ antes de cometerem qualquer crime. É plausível que tecnologias biométricas possam ser utilizadas neste contexto”, afirma Hafner da Anistia.

Ele adverte que o impacto sobre as pessoas que já são marginalizadas e discriminadas pode ser desproporcional. Ele destaca que a polícia poderia, por exemplo, sob a justificativa de vigilância preventiva, decidir instalar câmeras fora dos locais onde os potenciais suspeitos se encontram, como uma mesquita que já esteja sendo observada.

“Esses sistemas apresentam problemas não apenas em termos do direito à igualdade e à não discriminação, mas também em termos de liberdade de expressão e de reunião, bem como do direito à privacidade”, avalia Hafner.

O texto da lei suíça antiterrorismo, de fato, especifica que “opiniões e atividades religiosas e filosóficas” podem ser objeto de vigilância e justificar o processamento de dados pessoais muito sensíveis (Art. 23h). Uma vez que a definição de terrorismo no texto é muito ampla, é provável que a lei seja aplicada de maneira mais abrangente e além do escopo inicialmente previsto, afirma o professor de direito Frédéric Bernard.

Com sua proposta de lei sobre a IA, a Comissão Europeia quer proibir a identificação biométrica nos espaços públicos de todos os estados-membros da UE e penalizar aqueles que não cumprirem a regra. Embora tenha uma lei de proteção de dados que está parcialmente de acordo com a legislação de privacidade da UE (GDPR, em inglês), a Suíça não dispõe de nada comparável à legislação tecnológica europeia.

“É por isso que deve voltar a negociar com a UE e ajudar a orientar o debate sobre a governança das novas tecnologias o mais rápido possível”, afirma Ricardo Chavarriaga, chefe do escritório suíço da CLAIRE (Confederação europeia de laboratórios de pesquisa em IA, na sigla em inglês), à SWI swissinfo.ch.

Um novo padrão?

A lei proposta pela Comissão Europeia permite o uso do reconhecimento facial no caso de “crimes graves”, principalmente associados ao terrorismo. Todavia, de acordo com Chavarriaga e outros especialistas, ela marca um avanço significativo na área e está destinada a se tornar um padrão no setor da alta tecnologia.

É por isso que Chavarriaga acredita que os custos de um alinhamento tardio ou inexistente com a legislação europeia seriam muito altos para a Suíça. O especialista em IA teme não apenas pela competitividade dos produtos tecnológicos suíços no mercado global, mas também pelos direitos humanos.

“Algumas áreas de aplicação de tecnologias de alto risco, como as utilizadas pela polícia para impor a lei, podem ter efeitos prejudiciais para a população”, diz ele. “As forças policiais são apenas o último elemento da cadeia: os sistemas utilizados são produzidos por empresas que prometem economizar dinheiro e aumentar a eficiência, muitas vezes sem oferecer nenhuma garantia real”. É por isso que é tão importante estabelecer padrões.

“Ninguém compraria um elevador sem um certificado de segurança, ou um relógio que não funciona”, destaca Chavarriaga, que acredita que critérios devem ser proporcionais aos riscos. Por que os sistemas de IA deveriam ser uma exceção, especialmente quando os direitos fundamentais estão em jogo?

Adaptação: Clarice Dominguez